Wenn du mir schon eine Weile auf diesem Blog folgst, weißt du: Ollama war bislang vor allem eine Lösung, um große Sprachmodelle lokal auf dem eigenen Rechner laufen zu lassen. Ich habe Ollama hier im Blog schon mehrmals vorgestellt und darüber geschrieben, wie man Modelle zieht, betreibt und mit ihnen interagiert – mit dem Vorteil, dass die Daten lokal bleiben und man Unabhängigkeit gewinnt. Aber natürlich war das mit Nachteilen verbunden: Wenn dein Rechner nicht genügend Rechenpower hat, kannst du spürbare Geschwindigkeitseinbußen erleben.

Nun aber wagt Ollama einen großen Schritt: Sie bieten Cloud-Modelle an – also Modelle, die nicht mehr lokal, sondern in der Cloud auf leistungsstarken Rechenknoten betrieben werden. Damit verschiebt sich vieles: Man behält den Komfort von Ollama, bekommt aber Leistung, die weit über das hinausgeht, was ein durchschnittlicher Desktop- oder Laptop-PC leisten kann.

Was sind die neuen Cloud-Modelle und wie funktionieren sie?

Am 19. September 2025 hat Ollama seine Cloud Models veröffentlicht. Das Besondere: Du brauchst nur einen kostenlosen Ollama-Account, meldest dich über die Kommandozeile an, wählst ein Cloud-Modell aus und kannst dann ganz normal mit dem Modell chatten – fast so, als wäre es lokal.

Aktuell verfügbare Modelle

Zur Zeit stehen vier Modelle zur Verfügung (mit dem -cloud-Suffix):

qwen3-coder:480b-cloudgpt-oss:120b-cloudgpt-oss:20b-clouddeepseek-v3.1:671b-cloud

Diese Modelle laufen auf Serverhardware, sodass Speicher, Rechenleistung und Durchsatz deutlich höher sind als bei lokalem Einsatz. Wichtig: Ollama betont, dass die Cloud nicht dauerhaft deine Daten speichert – Datenschutz und Privatsphäre bleiben ein zentrales Thema.

Einstieg & Nutzung

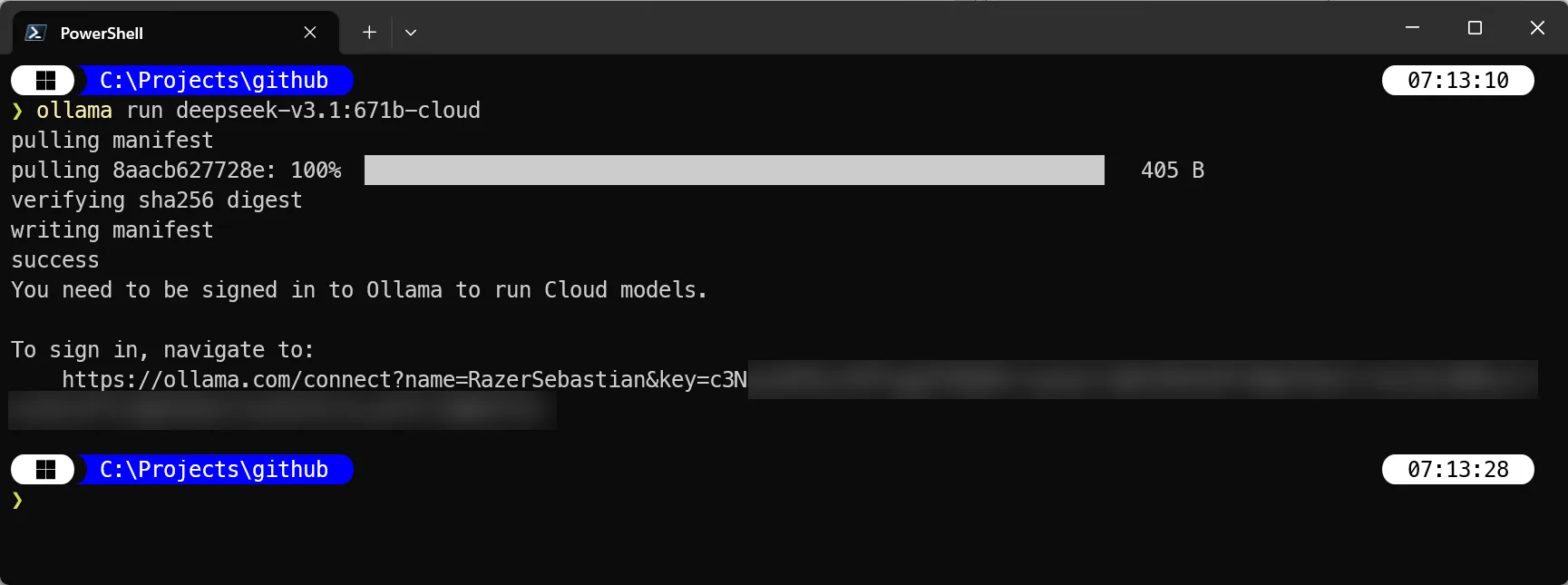

Zunächst muss Ollama mindestens in der Version 0.12 installiert werden.

Im Terminal kann man sich dann über den Befehl ollama signin anmelden.

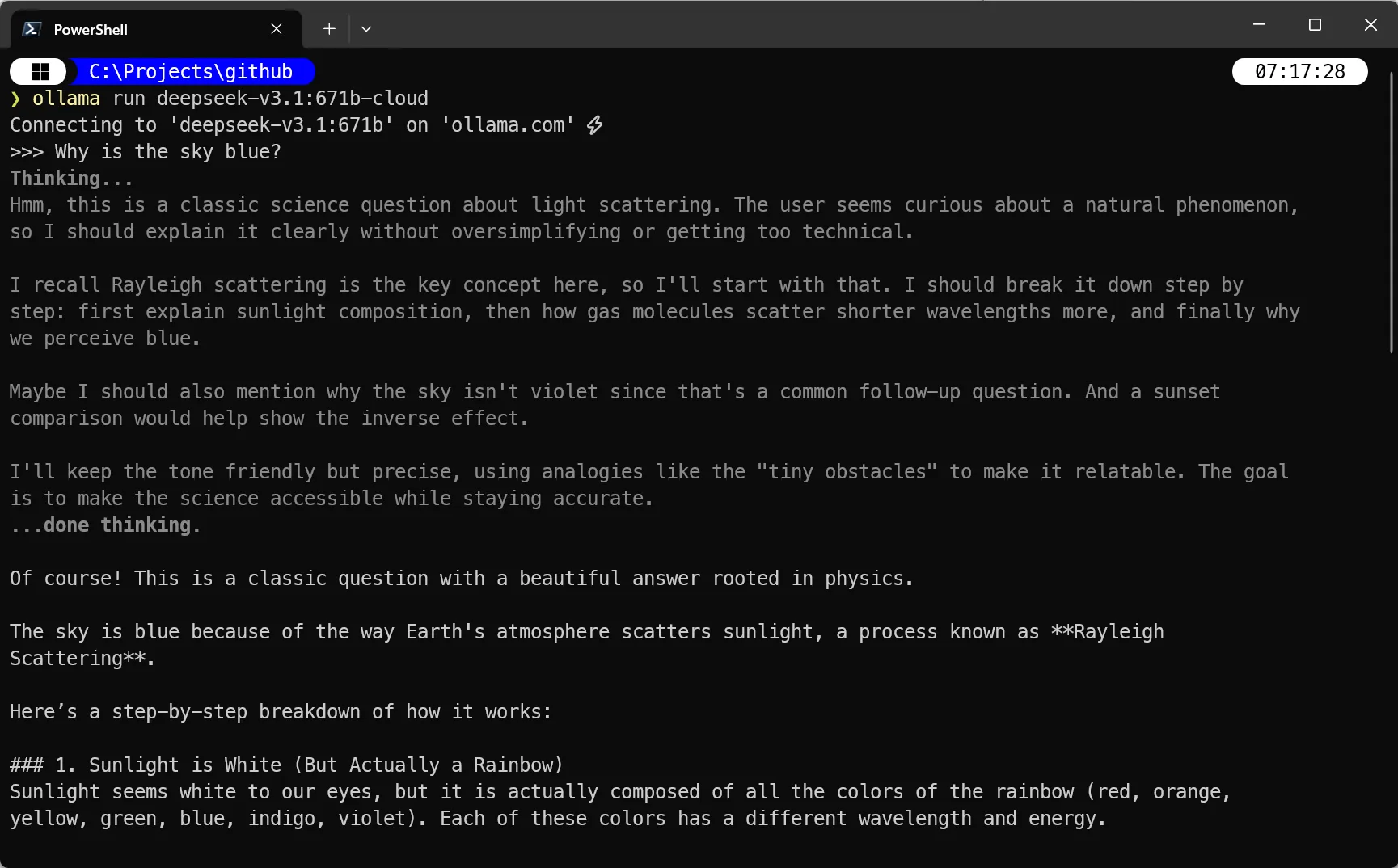

Danach kann man ein Cloud-Modell starten, z.B. ollama run deepseek-v3.1:671b-cloud

Genau wie bei lokalen Modellen kannst du danach Befehle wie ls, cp, pull, run usw. verwenden.

Außerdem sind die Cloud-Modelle bereits über Ollamas API nutzbar – also direkt aus Code (z. B. JavaScript, Python) ohne explizites Einloggen via CLI.

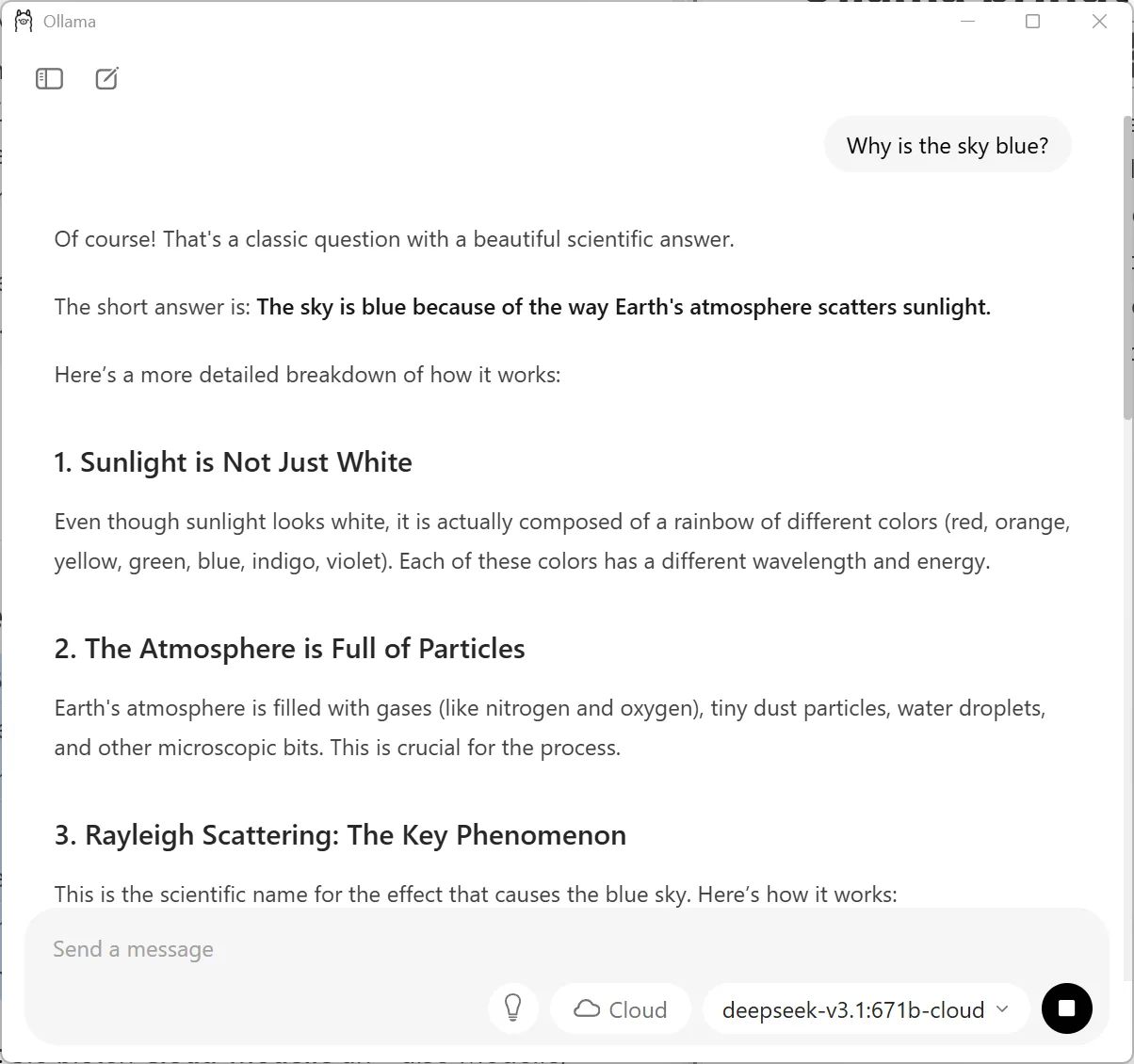

Außerdem kann man auch über die neue Oberfläche bequem mit dem Cloud-Modell chatten.

Vorteile und Grenzen

Vorteile

Mehr Leistung, weniger Wartezeit: Besonders bei großen Modellen (z. B. 120B, 480B) kann ein durchschnittlicher Rechner schnell zum Flaschenhals werden. Die Cloud-Variante umgeht dieses Problem.

Einheitliches Erlebnis: Du arbeitest mit denselben Kommandos und Werkzeugen, die du auch schon aus dem lokalen Einsatz kennst.

Skalierbarkeit: Wenn du später größere Modelle brauchst oder komplexere Aufgaben, musst du nicht zwangsläufig lokal aufrüsten.

Datenschutz bleibt Thema: Ollama gibt an, dass sie in Bezug auf Cloud-Inferenz keine Daten dauerhaft speichern.

Grenzen und Herausforderungen

Preview-Status: Es handelt sich derzeit um eine Vorschaufassung – nicht alle Bugs sind ausgemerzt, und das Modellangebot kann sich noch ändern.

Netzwerkabhängigkeit: Da Rechenzeit über das Netz bezogen wird, sind Latenzen und Bandbreite wichtige Faktoren – besonders bei interaktiven Chat-Anwendungen.

Kostenaspekt (zukünftig): Während der Preview kostenlose Nutzung möglich ist, ist nicht ausgeschlossen, dass später Gebühren für intensivere Nutzung erhoben werden.

Modellanzahl begrenzt: Noch sind nur vier Modelle verfügbar – die Auswahl ist also eingeschränkt.

Fazit

Mit den neuen Cloud-Modellen macht Ollama einen bedeutenden Schritt in Richtung flexibler, leistungsstarker KI-Nutzung — ohne dass jeder Nutzer selbst Hochleistungs-Hardware besitzen muss. Während ich hier im Blog bereits mehrfach darüber schrieb, wie attraktiv der lokale Betrieb von Ollama-Modellen ist, schafft die Cloud-Option nun eine elegante Ergänzung: Du behältst deine gewohnten Werkzeuge, bekommst aber Zugriff auf Rechenleistung auf Rechenzentrumsniveau.